La inteligencia artificial plantea un "riesgo de extinción" similar a las pandemias y la guerra nuclear

Tecnología

Un grupo de más de 300 expertos e investigadores, entre ellos el director ejecutivo de Google DeepMind o el de OpenAI, Sam Altman, publican una carta abierta

Sam Altman pide regular herramientas como ChatGPT por su capacidad de "hacer daño"

Los expertos de la UE piden no caer en el alarmismo y legislar rápido

La inteligencia artificial (IA) plantea un "riesgo de extinción" comparable al de las pandemias o la guerra nuclear, advierte en una carta abierta un grupo de más de 300 expertos e investigadores de la industria, entre los que se encuentran el director ejecutivo de Google DeepMind, Demis Hassabis; Dario Amodei, director ejecutivo de Anthropic, y el director ejecutivo de OpenAI, Sam Altman, entre otros.

"Mitigar el riesgo de extinción de la IA debería ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear", dice el comunicado de un párrafo publicado por Center for AI Safety, una organización sin fines de lucro con sede en San Francisco.

Otros de los firmantes del comunicado son Geoffrey Hinton -quien fue bautizado como el padrino de la IA y desarrolló parte de su carrera en Google- y Youshua Bengio, dos de los tres investigadores de IA que ganaron el Premio Turing 2018 -el Nobel de la informática- por su trabajo en IA.

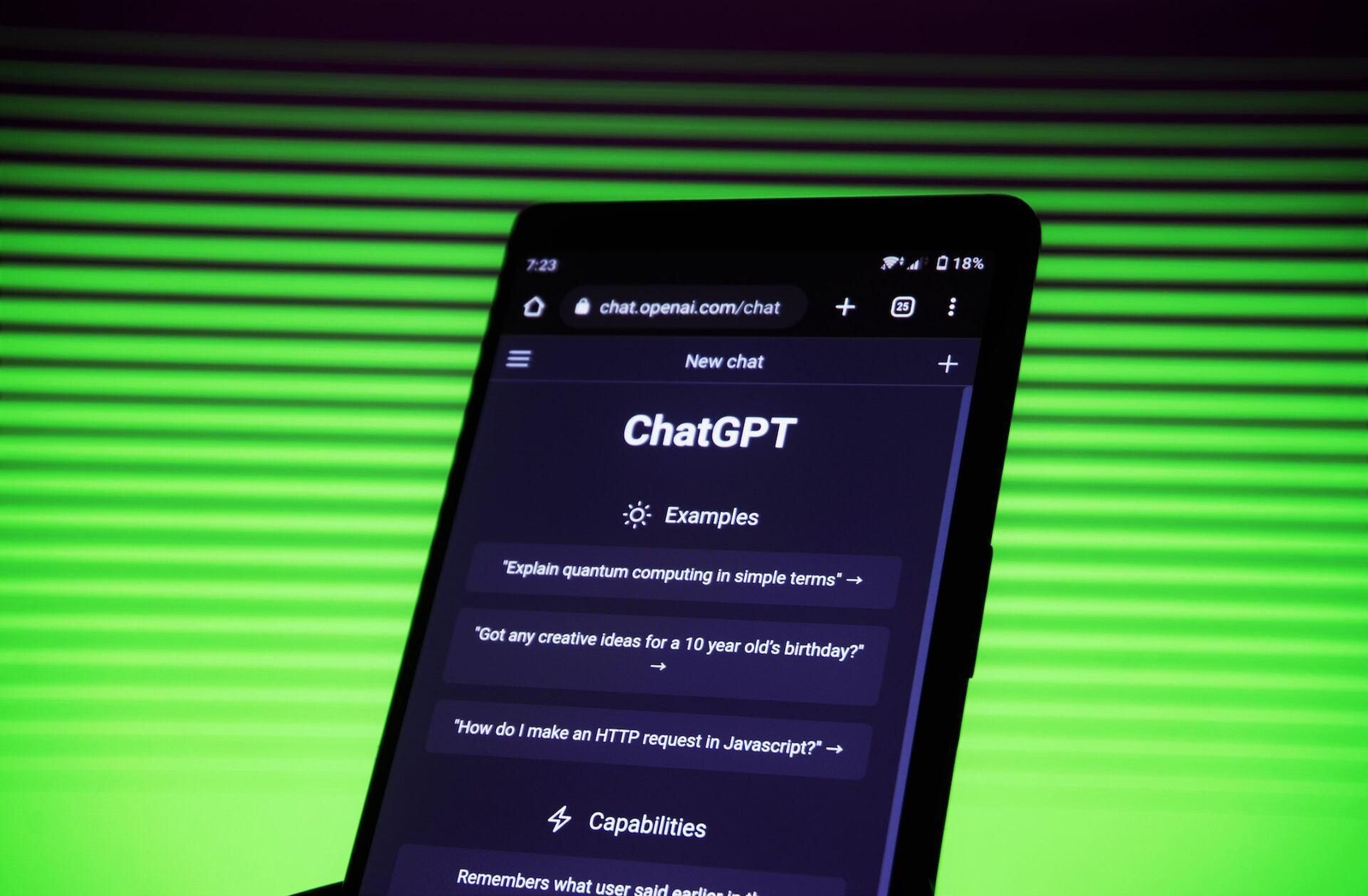

Desde que el chatbot de OpenAI, ChatGPT, se lanzó en noviembre de 2023 ha aumentado la preocupación sobre las consecuencias que podría conllevar el éxito de esta tecnología, siendo dos de los mayores temores la difusión a gran escala de desinformación y propaganda y la posible eliminación de trabajos de todo tipo.

Más inteligentes que los seres humanos

Por su parte, Hinton, en una reciente entrevista con The New York Times el pasado 1 de mayo, fue un paso más lejos y señaló su preocupación por que esta tecnología supere la capacidad intelectual de un humano.

"La idea de que estas cosas en realidad podrían volverse más inteligentes que las personas, algunas personas lo creían", explicó en esa entrevista. "Pero la mayoría de la gente pensaba que estaba muy lejos. Yo pensaba que estaba muy lejos. Pensaba que faltaban entre 30 y 50 años o incluso más. Obviamente, ya no pienso eso", comentó Hinton entonces.

Este mes, Altman, Hassabis y Amodei se reunieron con el presidente de Estados Unidos, Joe Biden, y la vicepresidenta, Kamala Harris, para hablar sobre la regulación de la AI.

Además, el director ejecutivo de OpenAI testificó ante el Senado y advirtió que los riesgos de esta tecnología eran lo suficientemente serios como para justificar la intervención del Gobierno.

En marzo, más de mil empresarios e investigadores del sector tecnológico -entre ellos Elon Musk, quien no firma esta última carta- solicitaron en una misiva de tono apocalíptico que se suspendan durante seis meses los sistemas de IA "más poderosos que GPT-4" (el último modelo de lenguaje desarrollado por OpenAI).

También te puede interesar

Lo último